剛小步快跑了一波GPT 5.1,主打讓大模型說人話,OpenAI又在可解釋性上做文章了。

真的是paper的那種。

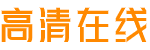

論文公開了OpenAI內部一種訓練小模型的新方法,能讓模型的內部機制更容易被人類理解,即更具可解釋性。

OpenAI自己是這樣介紹的:

- ChatGPT背后的語言模型具有復雜且時長令人驚訝的結構,我們尚未完全了解它們是如何工作的。

這種方法有助于我們縮小其中的差距。

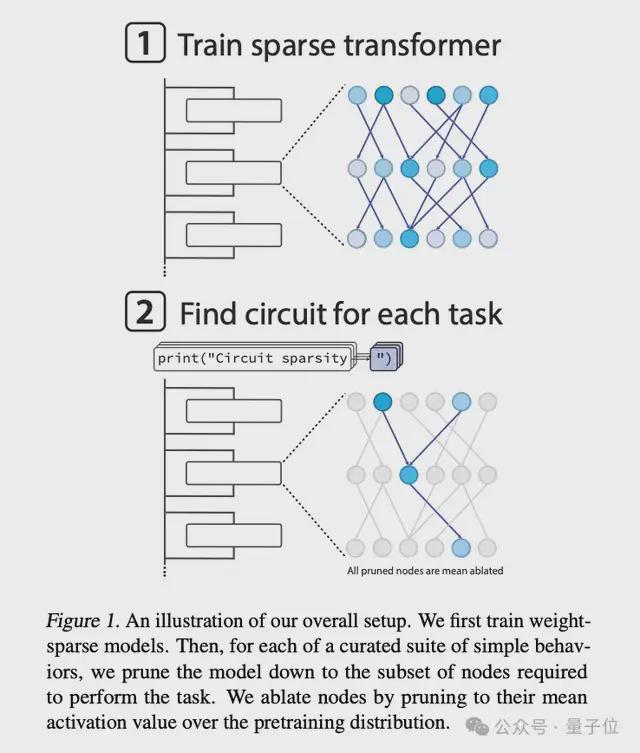

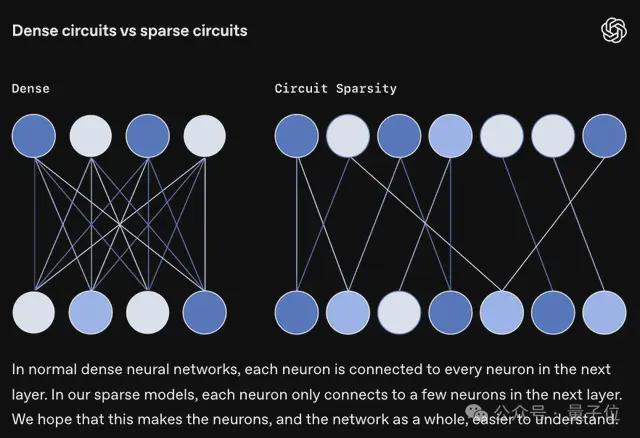

簡單來說,在這項研究中,OpenAI研究員們的核心思路是:訓練神經元連接少、但神經元數量多的稀疏模型,讓神經網絡變得簡單,也更容易理解。

如果你對模型可解釋性感興趣,這篇論文值得一讀。

而對于OpenAI的難得open,還有不少網友關心:那么新的小模型系列要來了嗎?

通過稀疏模型理解神經網絡

來看具體研究內容。

OpenAI研究員們認為,推理模型通過思維鏈展現出的可解釋性在短期內非常有價值,能讓我們捕捉到模型的“欺騙”等行為。但完全依賴這一特性顯然不太可靠,隨著時間的推移,這種策略也可能會失效。

想要更本質地理解模型機制,還是需要對模型的計算過程進行完全逆向工程。

問題在于,從復雜密集網絡入手,難度非常大:每個神經元都與其他數千個神經元相連,不同的神經元又執行著許多不同的功能,這讓理解它們看上去幾乎不可能。

那么,能否訓練一個擁有很多神經元,但每個神經元只有幾十個連接的模型,來幫助人們理解模型機制呢?

基于這一核心思路,OpenAI的研究人員訓練了一個小模型:采用的還是現代語言模型的基礎架構(類似GPT-2),只做了一個小小的改動——

強制將模型的大部分權重設為0。

評估可解釋性

有了這個稀疏模型,下一步,研究人員的目標是,找出模型在每一項任務中的“回路(circuit)”。